在马尔可夫决策过程中,当智能体从一个状态S,选择动作A,会进入另外一个状态S'。同时,也会给智能体奖励R。

奖励既有正,也有负,正代表我们鼓励智能体在这个状态下继续这么做,负得话代表我们并不希望智能体这么做。 在强化学习中,我们会用奖励R作为智能体学习的引导,期望智能体获得尽可能多的奖励。

需要注意的是:很多时候,我们并不能单纯通过R来衡量一个动作的好坏。我们必须用长远的眼光来看待问题。我们要把未来的奖励也计算到当前状态下,再进行决策。-

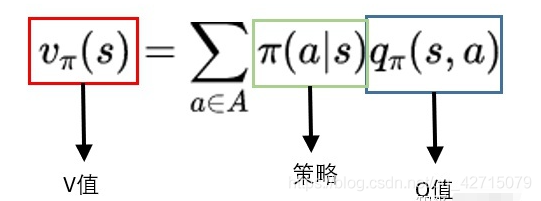

评估状态的价值,我们称为V值。它代表了智能体在这个状态下,一直到最终状态的奖励总和的期望。

评估动作的价值,我们称为Q值。它代表了智能体选择这个动作后,一直到最终状态奖励总和的期望。

一个状态的V值就是这个状态下所有动作的Q值,如下图所示: