1、网络权重初始化存在的问题

早期的参数初始化方法普遍随机初始化。最常用的随机初始化方法是从均值为0、方差为1的高斯分布中随机采样得到权重。需要注意的是,随机初始化所使用的值的范围可能会对网络性能产生重大影响。如果权重以过大或过小的值初始化,可能会导致训练过程收敛缓慢甚至导致网络发散。

2、Xavier Initialization诞生背景

Xavier初始化的作者Xavier Glorot,在《Understanding the difficulty of training deep feedforward neural networks》论文中提出一个洞见:激活值的方差是逐层递减的,这导致反向传播中的梯度也逐层递减。要解决梯度消失,就要避免激活值方差的衰减,最理想的情况是,每层的输出值(激活值)保持高斯分布。就这个想法,Xavier Glorot新的初始化方法,后来称之为“Xavier Initialization”

3、Xavier Initialization详细介绍

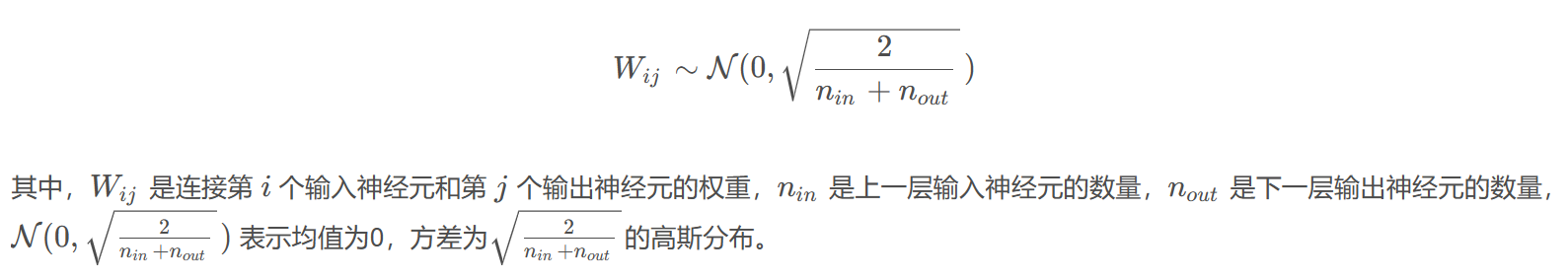

Xavier Initialization(也称为Glorot Initialization)是一种常用的神经网络权重初始化方法,旨在解决随机初始化可能导致的梯度消失或梯度爆炸问题。它的基本思想是根据上一层输入神经元的数量和下一层输出神经元的数量来确定权重初始化的范围。

Xavier Initialization的公式为:

Xavier Initialization的优点是可以有效地避免梯度消失或梯度爆炸问题,并且可以加速神经网络的收敛速度。然而,它的缺点是在某些情况下可能会导致权重太小或太大,从而影响网络的性能。因此,一些改进的技术,如Kaiming Initialization和其变体已经被提出来以进一步提高随机初始化的性能。

总的来说,Xavier Initialization是一种简单而有效的神经网络权重初始化方法,尤其适用于激活函数为tanh或sigmoid的情况。通过调整初始化权重的范围,可以有效地提高网络的训练速度和性能。

4、Xavier Initialization的改进

Kaiming Initialization是一种改进的神经网络权重初始化方法,它是Xavier Initialization的一个变体。与Xavier Initialization不同,Kaiming Initialization主要用于激活函数为ReLU(Rectified Linear Unit)的神经网络。

5、读者推荐

网络参数初始化是PyTorch的基础和核心,推荐大家关注《PyTorch面试精华》