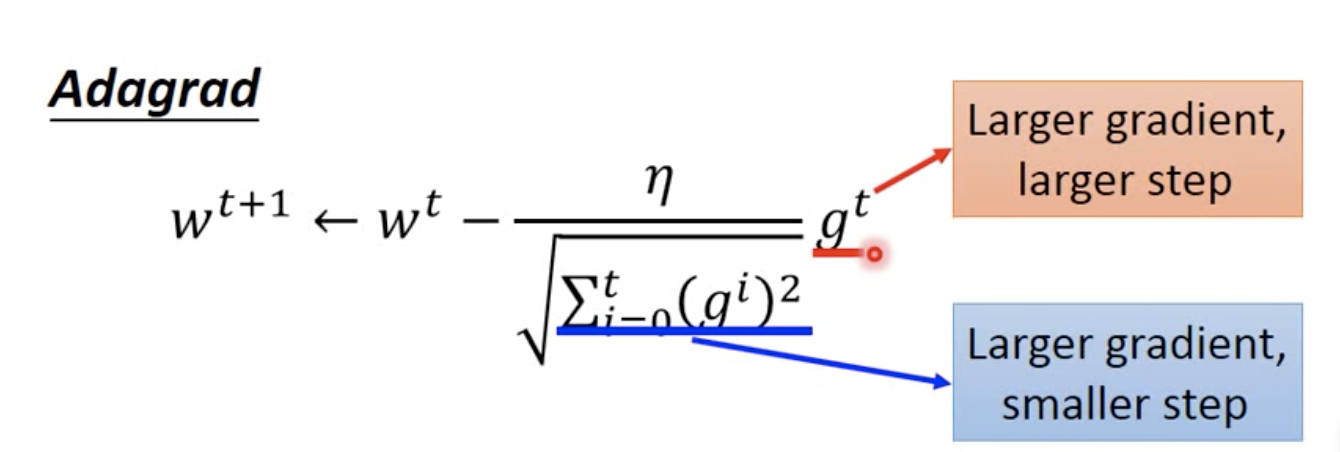

AdaGrad是解决不同参数应该使用不同的更新速率的问题。Adagrad自适应地为各个参数分配不同学习率的算法。其公式如下:

但是我们发现一个现象,本来应该是随着gradient的增大,我们的学习率是希望增大的,也就是图中的gt;但是与此同时随着gradient的增大,我们的分母是在逐渐增大,也就对整体学习率是减少的,这是为什么呢?

这是因为随着我们更新次数的增大,我们是希望我们的学习率越来越慢。因为我们认为在学习率的最初阶段,我们是距离损失函数最优解很远的,随着更新的次数的增多,我们认为越来越接近最优解,于是学习速率也随之变慢。

# coding: utf-8

import numpy as np

class AdaGrad:

def __init__(self, learning_rate=0.01):

self.learning_rate = learning_rate

self.h = None

def update(self, params, grads):

if self.h is None:

self.h = {}

for key, value in params.items():

self.h[key] = np.zeros_like(value)

for key in params.keys():

self.h[key] += grads[key] * grads[key]

params[key] -= self.learning_rate * grads[key] / (np.sqrt(self.h[key]) + 1e-07)

# 1e-07微小值避免分母为0